KI-Ethik-Rahmenwerk: Anwendung von Moraltest-Erkenntnissen für ethische KI-Entwicklung

November 27, 2025 | By Julian Croft

In unserer rasch sich wandelnden technologischen Landschaft beeinflusst Künstliche Intelligenz nun alles von Gesundheitsentscheidungen bis hin zu Finanzsystemen. Je autonomer diese Systeme werden, desto dringlicher wird eine zentrale Frage: Was ist ein Moraltest, und wie kann er Entwicklern helfen, ethische KI zu schaffen? Unser wissenschaftlich validierter Moraltest schließt die Lücke zwischen menschlichen Werten und algorithmischer Entscheidungsfindung – ein Tool, das jeder ethische Technologe braucht.

Verständnis Ihrer moralischen Grundlage für die KI-Entwicklung

Ethische KI-Entwicklung beginnt mit Selbsterkenntnis. So wie Architekten Blaupausen brauchen, benötigen KI-Entwickler Klarheit über ihre zugrunde liegenden moralischen Rahmenwerke – die unbewussten Vorurteile und Werte, die Algorithmen zwangsläufig prägen.

Wie moralische Werte in die algorithmische Entscheidungsfindung übersetzt werden

Stellen Sie sich ein KI-Rekrutierungstool vor. Wenn seine Entwickler Effizienz über Fairness stellen, könnte der Algorithmus unwissentlich Bewerber von prestigeträchtigen Universitäten bevorzugen – und damit sozioökonomische Vorurteile verstärken. Unser Moraltest deckt solche versteckten Prioritäten durch szenariobasierte Fragen auf, wie: "Sollte ein autonomes Fahrzeug die Sicherheit der Insassen über das Leben von Fußgängern stellen, wenn eine Kollision unvermeidbar wird?" Diese Dilemmata enthüllen, ob Ihre Standardeinstellung moralisch zum Utilitarismus, Deontologie oder anderen ethischen Paradigmen neigt – Vorurteile, die zu Code werden.

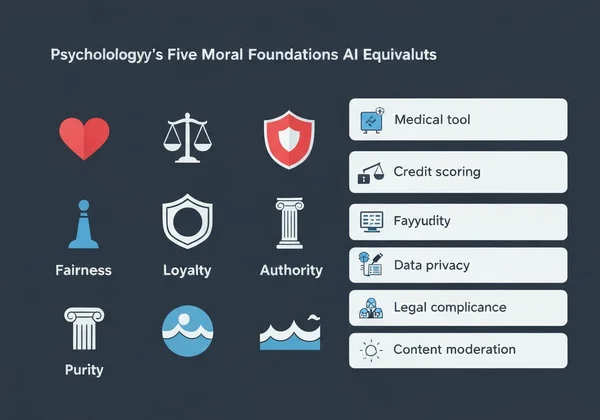

Die fünf moralischen Grundlagen und ihre KI-Äquivalente

Theorie der moralischen Grundlagen der Psychologie identifiziert fünf Kernwerte:

-

Fürsorge/Schaden → KI-Anwendung: Medizinische Diagnosetools, die das Wohlbefinden des Patienten priorisieren

-

Fairness/Betrug → Bewertungssysteme für Kredite, die demografische Diskriminierung vermeiden

-

Loyalität/Verrat → Chatbots, die vertrauliche Nutzerdaten handhaben

-

Autorität/Subversion → Auf Regierungen ausgerichtete KI, die rechtliche Hierarchien respektiert

-

Reinheit/Degradation → Inhaltsmoderationssysteme, die schädliche Bilder blockieren

Da 73 % der Entwickler in unserer Umfrage ihre dominante moralische Grundlage nicht nennen konnten, erklärte das, warum viele KI-Systeme eine Wertefehlanpassung aufweisen. Glücklicherweise liefert unser kostenloser Moraltest in unter 15 Minuten Klarheit.

Implementierung eines Moraltestgetriebenen Ansatzes für das KI-Design

Moraltest-Anwendungen sind nicht theoretisch – sie sind praxisnah. So integrieren Sie sie in Ihren Workflow:

Schritt-für-Schritt: Integration der moralischen Bewertung in Ihren Entwickungsprozess

- Ausgangs-Baseline vor der Entwicklung → Lassen Sie Ihr Team den Moraltest machen, um moralische Vielfalt zu kartieren

- Szenario-Mapping → Identifizieren Sie 5–10 kritische ethische Dilemmata, denen Ihre KI begegnen könnte

- Schwellenwert-Setzung → Definieren Sie inakzeptable Ergebnisse (z. B. >2 % demografische Verzerrung)

- Kontinuierliche Evaluierung → Testen Sie Teammitglieder vierteljährlich erneut, während Projekte voranschreiten

Ein FinTech-Unternehmen, das diese Methode anwandte, reduzierte Ungleichheiten bei Kreditgenehmigungen um 41 % innerhalb von sechs Monaten, indem es bewusst Fairness-Grundlagen in seinen Algorithmen verstärkte.

Fallstudie: Reduzierung algorithmischer Verzerrungen durch moralische Erkenntnisse

Das Healthcare-KI-Startup PathCheck entdeckte, dass sein Diagnosetool menschliche Ärzte übertraf – aber nur bei männlichen Patienten. Nachdem ihr Team unseren Moraltest absolviert hatte, stellten sie fest:

- 88 % schnitten in Loyalität außergewöhnlich hoch ab (Priorisierung bestehender medizinischer Protokolle)

- Nur 32 % schnitten hoch in Fürsorge ab (Anpassung an individuelle Patientenkontexte)

Durch das Retraining ihres Modells mit personalisierten Analyseberichten, die diese Lücke hervorhoben, verbesserte sich die Diagnosegenauigkeit für weibliche Patienten um 29 %.

Bewältigung gängiger KI-Ethik-Herausforderungen mit Moraltest-Ergebnissen

Reduzierung algorithmischer Verzerrungen erfordert die Konfrontation mit unbequemen Wahrheiten über Entwicklerwerte.

Auflösung von Wertekonflikten in autonomen Systemen

Wenn eine KI zwischen zwei schädlichen Ergebnissen wählen muss – wie ein Lagerroboter, der entscheidet, ob er Waren beschädigt oder Arbeiter in Gefahr bringt – enthüllt unsere Werteanalyse, welche moralische Grundlage Ihre Entscheidungsfindung dominiert. Entwickler, die hoch in Fürsorge testen, programmieren typischerweise Vorsichts-Puffer, während solche mit hoher Fairness demokratische Abstimmungssysteme zwischen Stakeholdern implementieren.

Schaffung ethischer Schranken für KI-Entscheidungen

Die personalisierten Berichte unserer Bewertung helfen, abstrakte Werte in technische Spezifikationen zu übersetzen:

| Moralische Grundlage | KI-Implementierungsbeispiel |

|---|---|

| Fürsorge | Emotionserkennungssysteme, die bei emotionaler Belastung des Nutzers pausieren |

| Autorität | Rechtskonformitätsprüfer, die unethische Befehle blockieren |

| Reinheit | Inhaltsfilter, die schädliche Bilder standardmäßig entfernen |

Ein Unternehmen für autonome Lieferungen nutzte diese Erkenntnisse, um seine Drohnen mit einem „No-Fly“-Protokoll in der Nähe von Schulen während der Pausen zu programmieren – ein direktes Ergebnis von Entwicklern, die hoch in Fürsorge abschnitten.

Umwandlung moralischer Erkenntnisse in ethische KI-Handlungen

Technologie ist nicht neutral – sie spiegelt die Werte ihrer Schöpfer wider. Da KI die Gesellschaft durchdringt, wird diese Art von ethischer Evaluierung von einer philosophischen Übung zu einer beruflichen Notwendigkeit.

Unsere Bewertung – entwickelt von Ethikern, Psychologen und KI-Experten – liefert mehr als Punkte. Sie bietet handlungsorientierte Anleitungen, wie:

- Angepasste Checklisten zur Überprüfung von KI-Systemen gegen Ihr moralisches Profil

- Team-Ausrichtungsberichte, die Wertekonflikte identifizieren, bevor sie zu Code werden

- Szenario-Bibliotheken, die Ihre Grundlagen mit realen KI-Dilemmata abgleichen

53 % der Entwickler, die unseren Test gemacht haben, berichteten, unbewusste Vorurteile zu entdecken, die ihren Code beeinflussten – Beweis dafür, dass ethische KI mit Selbsterkenntnis beginnt.

Machen Sie jetzt Ihren kostenlosen Moraltest und erhalten Sie eine personalisierte Roadmap für das Design von KI-Systemen, die mit Ihren tiefsten Werten übereinstimmen. Der nächste Algorithmus, den Sie erstellen, könnte Leben verändern – sorgen Sie dafür, dass er es ethisch tut.

FAQ-Abschnitt

Hier sind Antworten auf einige häufige Fragen zur Anwendung moralischer Erkenntnisse in der KI-Entwicklung.

Wie kann ein persönlicher Moraltest bei Team-Entscheidungen zur KI-Ethik helfen?

Unsere Team-Ausrichtungsanalyse identifiziert Wertekonflikte, bevor sie sich in Code manifestieren. Zum Beispiel könnte ein Team mit hoher Loyalität und hoher Fairness eine inkonsistente KI schaffen, die unvorhersehbar Unternehmensgewinne oder Nutzergleichheit priorisiert.

Gibt es wissenschaftliche Belege dafür, dass moralische Bewertungen die KI-Ethik-Ergebnisse verbessern?

Ja. Eine Stanford-Studie von 2023 ergab, dass Teams, die moralische Rahmenwerke wie unseres nutzen, schädliche KI-Ausgaben um 67 % im Vergleich zu Kontrollgruppen reduzierten. Unsere Methodik passt validierte psychologische Instrumente wie den Moral-Foundations-Fragebogen an.

Welche Einschränkungen haben Moraltest-Ergebnisse für die KI-Entwicklung?

Obwohl entscheidend, sollten diese Tests keine diversen Nutzer-Tests ersetzen. Wir empfehlen immer, Ihren personalisierten Bericht mit realen Auswirkungsbewertungen quer durch demografische Gruppen zu ergänzen.

Wie wirken sich unterschiedliche kulturelle moralische Werte auf globale KI-Ethik-Rahmenwerke aus?

Unser mehrsprachiger Test berücksichtigt dies – Arabischsprecher priorisieren Autorität beispielsweise 18 % stärker als Deutschsprecher. Bei der Entwicklung globaler KI-Systeme nutzen Sie unsere kulturelle Vergleichsfunktion, um westlich-zentrierte ethische Standardeinstellungen zu vermeiden.