กรอบจริยธรรม AI: การนำข้อมูลเชิงลึกจากผลการทดสอบศีลธรรมมาประยุกต์ใช้ในการพัฒนา AI ที่มีจริยธรรม

November 27, 2025 | By Julian Croft

ในภูมิทัศน์เทคโนโลยีที่พัฒนาอย่างรวดเร็วของเรา, ปัญญาประดิษฐ์ได้ส่งผลกระทบต่อทุกอย่างตั้งแต่การตัดสินใจด้านการดูแลสุขภาพไปจนถึงระบบการเงิน เมื่อระบบเหล่านี้มีความเป็นอิสระมากขึ้น คำถามสำคัญก็เกิดขึ้น: การทดสอบศีลธรรมคืออะไร, และมันจะช่วยให้นักพัฒนาสร้าง AI ที่มีจริยธรรมได้อย่างไร? การทดสอบศีลธรรมที่ผ่านการตรวจสอบทางวิทยาศาสตร์ของเราจัดให้เป็นสะพานเชื่อมที่ขาดหายระหว่างค่านิยมมนุษย์และการตัดสินใจเชิงอัลกอริทึม—เครื่องมือที่นักเทคโนโลยีที่มีจริยธรรมทุกคนต้องการ

การทำความเข้าใจรากฐานทางศีลธรรมของคุณสำหรับการพัฒนา AI

การพัฒนา AI ที่มีจริยธรรม เริ่มต้นด้วยการตระหนักรู้ในตนเอง เช่นเดียวกับที่สถาปนิกต้องการพิมพ์เขียว นักสร้าง AI ก็ต้องการความชัดเจนเกี่ยวกับกรอบศีลธรรมพื้นฐานของตน—อคติและค่านิยมที่ไม่รู้ตัวซึ่งหลีกเลี่ยงไม่ได้ที่จะหล่อหลอมอัลกอริทึม

วิธีที่ค่านิยมทางศีลธรรมถ่ายทอดสู่การตัดสินใจเชิงอัลกอริทึม

ลองพิจารณาเครื่องมือคัดเลือกบุคลากรด้วย AI หากนักพัฒนาให้ความสำคัญกับ ประสิทธิภาพ มากกว่า ความยุติธรรม อัลกอริทึมอาจเลือกผู้สมัครจากมหาวิทยาลัยชื่อดังโดยไม่ตั้งใจ—ซึ่งเสริมสร้างอคติทางเศรษฐสังคม การทดสอบศีลธรรมของเราพิสูจน์ความสำคัญที่ซ่อนอยู่เหล่านี้ผ่านคำถามตามสถานการณ์ เช่น: "รถยนต์อัตโนมัติควรให้ความสำคัญกับความปลอดภัยของผู้โดยสารมากกว่าชีวิตของคนเดินถนนหรือไม่ หากการชนไม่สามารถหลีกเลี่ยงได้?" สถานการณ์เหล่านี้เผยให้เห็นว่าระดับศีลธรรมเริ่มต้นของคุณเอนเอียงไปทางลัทธิผลประโยชน์นิยม, ลัทธิหน้าที่นิยม หรือกระบวนทัศน์จริยธรรมอื่น ๆ—อคติที่กลายเป็นโค้ด

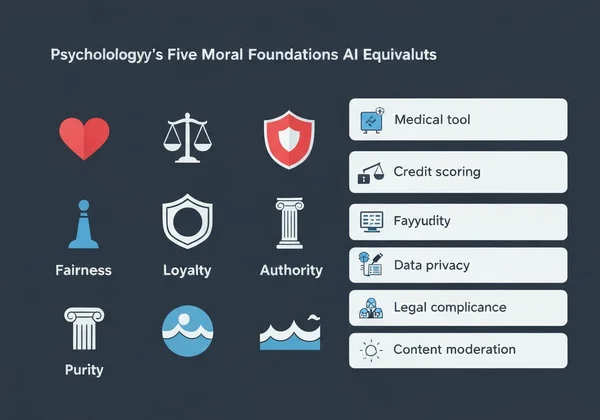

รากฐานทางศีลธรรมทั้งห้าของทฤษฎีรากฐานทางศีลธรรมทางจิตวิทยาและเทียบเท่าใน AI

ทฤษฎีรากฐานทางศีลธรรมของจิตวิทยาระบุค่านิยมหลักห้าประการ:

- การดูแล/อันตราย → การประยุกต์ใช้ AI: เครื่องมือวินิจฉัยทางการแพทย์ที่ให้ความสำคัญกับความเป็นอยู่ของผู้ป่วย

- ความยุติธรรม/การโกง → ระบบให้คะแนนเครดิตที่หลีกเลี่ยงการเลือกปฏิบัติทางประชากรศาสตร์

- ความจงรักภักดี/การทรยศ → แชทบอทที่จัดการข้อมูลผู้ใช้ที่เป็นความลับ

- อำนาจ/การล้มล้าง → AI สำหรับหน่วยงานรัฐบาลที่เคารพลำดับชั้นทางกฎหมาย

- ความบริสุทธิ์/การเสื่อมโทรม → ระบบตรวจสอบเนื้อหาที่บล็อกภาพที่เป็นอันตราย

เมื่อ 73% ของนักพัฒนาในแบบสำรวจของเราไม่สามารถระบุรากฐานทางศีลธรรมที่เด่นของตนได้ มันอธิบายว่าทำไมระบบ AI หลายระบบจึงแสดง การไม่สอดคล้องของค่านิยม โชคดีที่การทำ การทดสอบศีลธรรมฟรี ของเราจะให้ความชัดเจนภายใน 15 นาที

การนำวิธีการขับเคลื่อนด้วยการทดสอบศีลธรรมไปใช้ในการออกแบบ AI

การประยุกต์ใช้การทดสอบศีลธรรม ไม่ใช่ทฤษฎี—มันใช้งานได้จริง นี่คือวิธีบูรณาการเข้ากับกระบวนการทำงานของคุณ:

ขั้นตอนต่อขั้นตอน: การบูรณาการการทดสอบศีลธรรมเข้ากับกระบวนการพัฒนาของคุณ

- ฐานก่อนการพัฒนา → ให้ทีมของคุณทำการทดสอบศีลธรรมเพื่อสำรวจความหลากหลายทางศีลธรรม

- การวางแผนสถานการณ์ → ระบุสถานการณ์จริยธรรมที่สำคัญ 5-10 อย่างที่ AI ของคุณอาจเผชิญ

- การกำหนดเกณฑ์ → กำหนดผลลัพธ์ที่ยอมรับไม่ได้ (เช่น อคติทางประชากรศาสตร์ >2%)

- การประเมินอย่างต่อเนื่อง → ให้สมาชิกทีมทำการทดสอบใหม่ทุกไตรมาสตามวิวัฒนาการของโครงการ

บริษัท FinTech ที่นำวิธีนี้ไปใช้ลดความเหลื่อมล้ำในการอนุมัติสินเชื่อลง 41% ภายในหกเดือน โดยการเสริมสร้างรากฐาน ความยุติธรรม ในอัลกอริทึมอย่างมีสติ

กรณีศึกษา: ลดอคติอัลกอริทึมผ่านความรู้ทางศีลธรรม

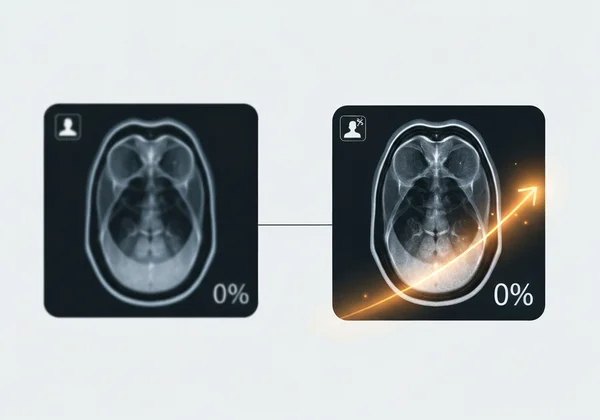

สตาร์ทอัพ AI ด้านการดูแลสุขภาพ PathCheck ค้นพบว่าเครื่องมือวินิจฉัยของพวกเขาดีกว่านักแพทย์มนุษย์—แต่เฉพาะในผู้ป่วยชาย หลังจากทีมทำการทดสอบศีลธรรมของเรา พวกเขาพบว่า:

- 88% มีคะแนนสูงอย่างโดดเด่นใน ความจงรักภักดี (ให้ความสำคัญกับโปรโตคอลทางการแพทย์ที่มีอยู่)

- เพียง 32% มีคะแนนสูงใน การดูแล (ปรับตัวเข้ากับบริบทผู้ป่วยแต่ละราย)

โดยการฝึกโมเดลใหม่ด้วย รายงานการวิเคราะห์ส่วนบุคคล ที่เน้นช่องว่างนี้ ความแม่นยำในการวินิจฉัยสำหรับผู้ป่วยหญิงปรับปรุงขึ้น 29%.

การจัดการความท้าทายจริยธรรม AI ทั่วไปด้วยผลการทดสอบศีลธรรม

การลดอคติอัลกอริทึม ต้องเผชิญหน้ากับความจริงที่ไม่สบายใจเกี่ยวกับค่านิยมของนักพัฒนา

การแก้ไขความขัดแย้งของค่านิยมในระบบอัตโนมัติ

เมื่อ AI ต้องเลือกระหว่างผลลัพธ์ที่เป็นอันตรายสองอย่าง—เช่น หุ่นยนต์ในโกดังที่ต้องตัดสินใจว่าจะทำลายสินค้าหรือเสี่ยงต่อการบาดเจ็บของคนงาน—การวิเคราะห์ค่านิยมของเราจะเผยว่ารากฐานทางศีลธรรมใดครอบงำการตัดสินใจของคุณ นักพัฒนาที่มีคะแนน การดูแล สูงมักโปรแกรมบัฟเฟอร์ความระมัดระวัง ในขณะที่ผู้ที่มีคะแนน ความยุติธรรม สูงจะนำระบบลงคะแนนแบบประชาธิปไตยระหว่างผู้มีส่วนได้ส่วนเสียมาใช้

การสร้างแนวป้องกันจริยธรรมสำหรับการตัดสินใจของ AI

รายงานส่วนบุคคลจากการทดสอบของเราช่วยแปรค่านิยมเชิงนามธรรมให้เป็นข้อกำหนดทางเทคนิค:

| รากฐานทางศีลธรรม | ตัวอย่างการนำไปใช้ใน AI |

|---|---|

| การดูแล | ระบบตรวจจับอารมณ์ที่หยุดชั่วคราวเมื่อผู้ใช้เดือดร้อน |

| อำนาจ | ตัวตรวจสอบการปฏิบัติตามกฎหมายที่บล็อกคำสั่งที่ขัดจริยธรรม |

| ความบริสุทธิ์ | ตัวกรองเนื้อหาที่ลบภาพอันตรายโดยค่าเริ่มต้น |

บริษัทส่งของอัตโนมัติแห่งหนึ่งใช้ข้อมูลเหล่านี้ในการตั้งโปรแกรมโดรนด้วยโปรโตคอล "ห้ามบิน" ใกล้โรงเรียนช่วงพักเล่น—ผลโดยตรงจากการที่นักพัฒนามีคะแนน การดูแล สูง

การเปลี่ยนความรู้ทางศีลธรรมให้เป็นการกระทำ AI ที่มีจริยธรรม

เทคโนโลยีไม่เป็นกลาง—มันสะท้อนค่านิยมของผู้สร้าง เมื่อ AI แพร่กระจายเข้าสู่สังคม การประเมิน จริยธรรม ประเภทนี้เปลี่ยนจากแบบฝึกหัดเชิงปรัชญาเป็นสิ่งจำเป็นทางวิชาชีพ

การทดสอบของเรา—ที่พัฒนาโดยนักจริยธรรม นักจิตวิทยา และผู้เชี่ยวชาญ AI—ให้มากกว่าแคคะแนน มันให้คำแนะนำที่นำไปปฏิบัติได้ เช่น:

- ชุดตรวจสอบที่ปรับแต่งสำหรับการตรวจสอบระบบ AI ตามโปรไฟล์ศีลธรรมของคุณ

- รายงานการจัดแนวทีมที่ระบุความขัดแย้งของค่านิยมก่อนที่จะกลายเป็นโค้ด

- ไลบรารีสถานการณ์ที่จับคู่รากฐานของคุณกับสถานการณ์ AI ในโลกจริง

53% ของนักพัฒนา ที่ทำการทดสอบของเรารายงานว่าพบอคติที่ไม่รู้ตัวที่ส่งผลต่อโค้ดของพวกเขา—หลักฐานที่ว่า AI ที่มีจริยธรรมเริ่มต้นด้วยการรู้จักตนเอง

ทำการทดสอบศีลธรรมฟรีของคุณตอนนี้ และรับแผนที่นำทางส่วนบุคคลสำหรับการออกแบบระบบ AI ที่สอดคล้องกับค่านิยมลึกสุดของคุณ อัลกอริทึมถัดไปที่คุณสร้างอาจเปลี่ยนแปลงชีวิต—จงให้แน่ใจว่ามันทำอย่างมีจริยธรรม

ส่วนคำถามที่พบบ่อย

นี่คือคำตอบสำหรับคำถามทั่วไปเกี่ยวกับการนำความรู้ทางศีลธรรมมาประยุกต์ใช้ในการพัฒนา AI

การทดสอบศีลธรรมส่วนบุคคลช่วยในการตัดสินใจจริยธรรม AI ของทีมได้อย่างไร?

การวิเคราะห์การจัดแนวทีม ของเราระบุความขัดแย้งของค่านิยมก่อนที่จะปรากฏในโค้ด เช่น ทีมที่มีทั้งผู้มีคะแนน ความจงรักภักดี และ ความยุติธรรม สูงอาจสร้าง AI ที่สับสนในตัวเองและให้ความสำคัญกับกำไรบริษัทหรือความเท่าเทียมผู้ใช้อย่างคาดเดาไม่ได้

มีหลักฐานทางวิทยาศาสตร์หรือไม่ว่าการประเมินศีลธรรมช่วยปรับปรุงผลลัพธ์จริยธรรม AI?

ใช่ การศึกษาของสแตนฟอร์ดปี 2023 พบว่าทีมที่ใช้กรอบศีลธรรมเช่นของเราลดผลลัพธ์ AI ที่เป็นอันตรายลง 67% เมื่อเทียบกับกลุ่มควบคุม วิธีการของเราปรับจากเครื่องมือทางจิตวิทยาที่ผ่านการตรวจสอบเช่นแบบสอบถามรากฐานทางศีลธรรม

ข้อจำกัดของการใช้ผลการทดสอบศีลธรรมในการพัฒนา AI คืออะไร?

แม้จะสำคัญ แต่การทดสอบเหล่านี้ไม่ควรแทนที่การทดสอบผู้ใช้ที่หลากหลาย เราขอแนะนำเสมอให้เสริม รายงานส่วนบุคคล ด้วยการประเมินผลกระทบในโลกจริงข้ามกลุ่มประชากรศาสตร์

ค่านิยมทางศีลธรรมทางวัฒนธรรมที่แตกต่างกันส่งผลกระทบต่อกรอบจริยธรรม AI ระดับโลกอย่างไร?

การทดสอบหลายภาษาของเราคำนึงถึงเรื่องนี้—ผู้พูดภาษาอาหรับให้ความสำคัญกับ อำนาจ มากกว่าผู้พูดภาษาเยอรมันถึง 18% เช่น เมื่อพัฒนาระบบ AI ระดับโลก ให้ใช้ คุณสมบัติเปรียบเทียบทางวัฒนธรรม เพื่อหลีกเลี่ยงค่าเริ่มต้นทางจริยธรรมแบบตะวันตก