Marco de Ética em IA: Aplicando Insights do Teste Moral ao Desenvolvimento Ético de IA

November 27, 2025 | By Julian Croft

No nosso panorama tecnológico em rápida evolução, a inteligência artificial agora influencia tudo, desde decisões de saúde até sistemas financeiros. À medida que esses sistemas se tornam mais autônomos, surge uma pergunta crítica: O que é um teste moral, e como ele pode ajudar os desenvolvedores a criar IA ética? Nossa avaliação moral validada cientificamente fornece o elo perdido entre valores humanos e tomada de decisão algorítmica — uma ferramenta que todo tecnólogo ético precisa.

Compreendendo Sua Fundação Moral para o Desenvolvimento de IA

O desenvolvimento de IA ética começa com autoconhecimento. Assim como arquitetos precisam de plantas, criadores de IA precisam de clareza sobre suas estruturas morais subjacentes — os vieses inconscientes e valores que inevitavelmente moldam os algoritmos.

Como os Valores Morais se Traduzem em Tomada de Decisão Algorítmica

Considere uma ferramenta de recrutamento por IA. Se seus desenvolvedores priorizarem eficiência sobre equidade, o algoritmo pode inadvertidamente favorecer candidatos de universidades prestigiosas — reforçando vieses socioeconômicos. Nossa avaliação moral revela essas prioridades ocultas por meio de perguntas baseadas em cenários como: "Um veículo autônomo deve priorizar a segurança do passageiro sobre a vida de pedestres se a colisão for inevitável?" Esses dilemas expõem se sua configuração moral padrão tende ao utilitarismo, deontologia ou outros paradigmas éticos — vieses que se tornam código.

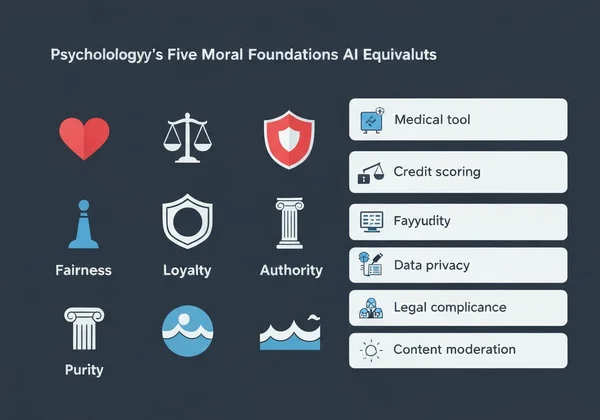

As Cinco Fundações Morais e Seus Equivalentes em IA

A Teoria das Fundações Morais da psicologia identifica cinco valores centrais:

- Cuidado/Dano → Aplicação em IA: Ferramentas de diagnóstico médico priorizando o bem-estar do paciente

- Fairness/Cheating → Equidade/Trapaça Sistemas de pontuação de crédito evitando discriminação demográfica

- Lealdade/Traição → Chatbots lidando com dados confidenciais de usuários

- Autoridade/Subversão → IA voltada para o governo respeitando hierarquias legais

- Pureza/Degradação → Sistemas de moderação de conteúdo bloqueando imagens prejudiciais

Quando 73% dos desenvolvedores em nossa pesquisa não conseguiram nomear sua fundação moral dominante, isso explicou por que muitos sistemas de IA exibem desalinhamento de valores. Felizmente, fazer nossa avaliação moral gratuita fornece clareza em menos de 15 minutos.

Implementando uma Abordagem Impulsionada por Teste Moral no Design de IA

As aplicações de teste moral não são teóricas — elas são operacionais. Veja como integrá-las ao seu fluxo de trabalho:

Passo a Passo: Integrando a Avaliação Moral à Sua Pipeline de Desenvolvimento

- Linha de Base Pré-Desenvolvimento → Tenha sua equipe realizar a avaliação moral para mapear a diversidade moral

- Mapeamento de Cenários → Identifique 5-10 dilemas éticos críticos que sua IA pode enfrentar

- Definição de Limiares → Determine resultados inaceitáveis (ex.: >2% de viés demográfico)

- Avaliação Contínua → Reavalie os membros da equipe trimestralmente à medida que os projetos evoluem

Uma empresa de FinTech que aplicou esse método reduziu disparidades na aprovação de empréstimos em 41% em apenas seis meses, ao amplificar conscientemente as fundações de equidade em seus algoritmos.

Estudo de Caso: Reduzindo Viés Algorítmico por Meio de Insights Morais

A startup de IA em saúde PathCheck descobriu que sua ferramenta de diagnóstico superava médicos humanos — mas apenas para pacientes do sexo masculino. Após a equipe realizar nossa avaliação moral, descobriram:

- 88% pontuaram excepcionalmente alto em lealdade (priorizando protocolos médicos existentes)

- Apenas 32% pontuaram alto em cuidado (adaptando-se a contextos individuais de pacientes)

Ao retrenar seu modelo com relatórios de análise personalizados destacando essa lacuna, a precisão diagnóstica para pacientes do sexo feminino melhorou em 29%.

Abordando Desafios Comuns de Ética em IA com Resultados de Teste Moral

A redução de viés algorítmico requer confrontar verdades desconfortáveis sobre os valores dos desenvolvedores.

Resolvendo Conflitos de Valores em Sistemas Autônomos

Quando uma IA deve escolher entre dois resultados prejudiciais — como um robô de armazém decidindo se danifica mercadorias ou arrisca ferir um trabalhador —, nossa análise de valores revela qual fundação moral domina sua tomada de decisão. Desenvolvedores que pontuam alto em cuidado geralmente programam buffers de segurança, enquanto os de alto equidade implementam sistemas de votação democrática entre partes interessadas.

Criando Guardrails Éticos para a Tomada de Decisão em IA

Os relatórios personalizados de nossa avaliação ajudam a traduzir valores abstratos em especificações técnicas:

| Fundação Moral | Exemplo de Implementação em IA |

|---|---|

| Cuidado | Sistemas de detecção de emoções pausando durante angústia do usuário |

| Autoridade | Verificadores de conformidade legal bloqueando comandos antiéticos |

| Pureza | Filtros de conteúdo removendo imagens prejudiciais por padrão |

Uma empresa de entregas autônomas usou esses insights para programar seus drones com um protocolo "no-fly" perto de escolas durante o recreio — um resultado direto de desenvolvedores pontuando alto em cuidado.

Transformando Insights Morais em Ação Ética em IA

A tecnologia não é neutra — ela reflete os valores de seus criadores. À medida que a IA permeia a sociedade, esse tipo de avaliação ética passa de um exercício filosófico a um imperativo profissional.

Nossa avaliação — desenvolvida por eticistas, psicólogos e especialistas em IA — entrega mais do que pontuações. Ela fornece orientação acionável, como:

- Listas de verificação personalizadas para auditar sistemas de IA contra seu perfil moral

- Relatórios de alinhamento de equipe identificando conflitos de valores antes que se tornem código

- Bibliotecas de cenários combinando suas fundações com dilemas reais de IA

53% dos desenvolvedores que fizeram nosso teste relataram descobrir vieses inconscientes afetando seu código — prova de que a IA ética começa com autoconhecimento.

Faça seu teste moral gratuito agora e receba um roteiro personalizado para projetar sistemas de IA alinhados aos seus valores mais profundos. O próximo algoritmo que você criar pode mudar vidas — garanta que o faça de forma ética.

Seção de Perguntas Frequentes

Aqui estão respostas para algumas perguntas comuns sobre a aplicação de insights morais ao desenvolvimento de IA.

Como um teste moral pessoal pode ajudar nas decisões éticas de IA da equipe?

Nossa análise de alinhamento de equipe identifica conflitos de valores antes que se manifestem no código. Por exemplo, uma equipe com pontuadores altos tanto em lealdade quanto em equidade pode criar uma IA incoerente que prioriza imprevisivelmente o lucro da empresa ou a igualdade do usuário.

Há evidências científicas de que avaliações morais melhoram os resultados de ética em IA?

Sim. Um estudo de Stanford de 2023 descobriu que equipes usando estruturas morais como a nossa reduziram saídas prejudiciais de IA em 67% em comparação com grupos de controle. Nossa metodologia adapta instrumentos psicológicos validados como o Questionário de Fundações Morais.

Quais são as limitações do uso de resultados de teste moral no desenvolvimento de IA?

Embora cruciais, esses testes não devem substituir testes com usuários diversos. Sempre recomendamos complementar seu relatório personalizado com avaliações de impacto no mundo real em grupos demográficos variados.

Como valores morais culturais diferentes impactam estruturas de ética em IA globais?

Nosso teste multilíngue leva isso em conta — falantes de árabe priorizam autoridade 18% mais do que falantes de alemão, por exemplo. Ao desenvolver sistemas de IA globais, use nosso recurso de comparação cultural para evitar padrões éticos centrados no Ocidente.