Framework per l'Etica dell'IA: Applicare le intuizioni del test morale allo Sviluppo Etico dell'IA

November 27, 2025 | By Julian Croft

Nel nostro panorama tecnologico in rapida evoluzione, l'intelligenza artificiale influenza ormai tutto, dalle decisioni sanitarie ai sistemi finanziari. Man mano che questi sistemi diventano sempre più autonomi, emerge una domanda cruciale: Cos'è un test morale, e come può aiutare gli sviluppatori a creare IA etica? La nostra valutazione morale scientificamente validata fornisce il collegamento mancante tra valori umani e processo decisionale algoritmico—uno strumento essenziale per ogni tecnologo etico.

Comprendere la Vostra Fondazione Morale per lo Sviluppo dell'IA

Lo sviluppo etico dell'IA inizia con la consapevolezza di sé. Proprio come gli architetti hanno bisogno di progetti, i creatori di IA necessitano di chiarezza sui loro framework morali sottostanti—i bias inconsci e i valori che inevitabilmente modellano gli algoritmi.

Come i Valori Morali si Traducono nel Processo Decisionale Algoritmico

Considerate uno strumento di reclutamento IA. Se i suoi sviluppatori danno priorità all'efficienza rispetto alla equità, l'algoritmo potrebbe involontariamente favorire candidati da università prestigiose—rafforzando il bias socioeconomico. La nostra valutazione morale rivela tali priorità nascoste attraverso domande basate su scenari come: "Un veicolo autonomo dovrebbe dare priorità alla sicurezza del passeggero rispetto alle vite dei pedoni se la collisione diventa inevitabile?" Questi dilemmi espongono se la vostra impostazione morale predefinita tende verso l'utilitarismo, la deontologia o altri paradigmi etici—bias che diventano codice.

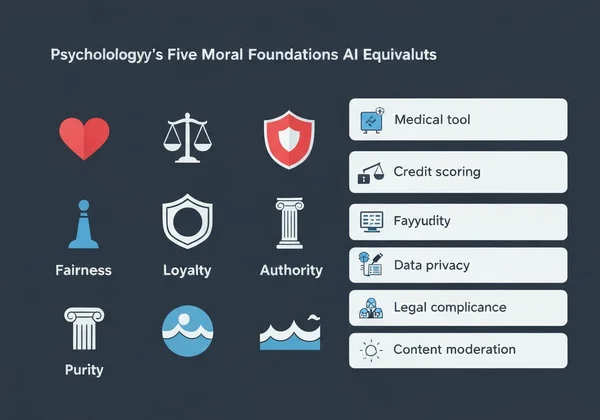

Le Cinque Fondamenta Morali e i Loro Equivalenti in IA

La Teoria delle Fondamenta Morali della psicologia identifica cinque valori centrali:

- Cura/Danno → Applicazione IA: Strumenti diagnostici medici che danno priorità al benessere del paziente

- Equità/Inganno → Sistemi di valutazione creditizia che evitano discriminazioni demografiche

- Lealtà/Tradimento → Applicazione IA: Chatbot che gestiscono dati utente confidenziali

- Autorità/Subversione → IA per enti governativi che rispetta le gerarchie legali

- Purezza/Degrado → Sistemi di moderazione dei contenuti che bloccano immagini dannose

Quando il 73% degli sviluppatori nel nostro sondaggio non riusciva a nominare la propria dominante fondazione morale, ciò spiegava perché molti sistemi IA presentano disallineamento di valori. Fortunatamente, effettuare la nostra valutazione morale gratuita fornisce chiarezza in meno di 15 minuti.

Implementare un Approccio Guidato dal Test Morale per lo Sviluppo dell'IA

Le applicazioni del test morale non sono teoriche—sono operative. Ecco come integrarle nel vostro flusso di lavoro:

Passo per Passo: Integrare la Valutazione Morale nella Vostra Pipeline di Sviluppo

- Baseline Pre-Sviluppo → Fate prendere alla vostra squadra la valutazione morale per mappare la diversità morale

- Mappatura degli Scenari → Identificate 5-10 dilemmi etici critici che la vostra IA potrebbe affrontare

- Impostazione delle Soglie → Determinate esiti inaccettabili (es. >2% di bias demografico)

- Valutazione Continua → Ritestate i membri del team trimestralmente man mano che i progetti evolvono

Un'azienda FinTech che ha applicato questo metodo ha ridotto le disparità nelle approvazioni di prestiti del 41% in sei mesi, amplificando consapevolmente le fondamenta di equità nei loro algoritmi.

Case Study: Ridurre il Bias Algoritmico Attraverso Intuizioni Morali

La startup IA sanitaria PathCheck ha scoperto che il loro strumento diagnostico superava i medici umani—ma solo per i pazienti maschi. Dopo che la loro squadra ha effettuato la nostra valutazione morale, hanno rilevato:

- L'88% aveva punteggi eccezionalmente alti in lealtà (priorità ai protocolli medici esistenti)

- Solo il 32% aveva punteggi alti in cura (adattamento ai contesti individuali dei pazienti)

Riallenando il loro modello con rapporti di analisi personalizzati che evidenziavano questa lacuna, l'accuratezza diagnostica per le pazienti donne è migliorata del 29%.

Affrontare le Sfide Comuni dell'Etica IA con i Risultati del Test Morale

La riduzione del bias algoritmico richiede di confrontarsi con verità scomode sui valori degli sviluppatori.

Risolvere Conflitti di Valori nei Sistemi Autonomi

Quando un'IA deve scegliere tra due esiti dannosi—come un robot da magazzino che decide se danneggiare merci o rischiare infortuni ai lavoratori—la nostra analisi dei valori rivela quale fondazione morale domina il vostro processo decisionale. Gli sviluppatori che risultano alti in cura programmano tipicamente buffer di cautela, mentre quelli alti in equità implementano sistemi di voto democratico tra stakeholder.

Creare Guardrail Etici per il Processo Decisionale IA

I rapporti personalizzati della nostra valutazione aiutano a tradurre valori astratti in specifiche tecniche:

| Fondamenta Morali | Esempio di Implementazione IA |

|---|---|

| Cura | Sistemi di rilevamento delle emozioni che mettono in pausa durante lo stress dell'utente |

| Autorità | Controlli di conformità legale che bloccano comandi non etici |

| Purezza | Filtri per i contenuti che rimuovono immagini dannose per impostazione predefinita |

Un'azienda di consegne autonome ha usato queste intuizioni per programmare i suoi droni con un protocollo "no-fly" vicino alle scuole durante l'ora di ricreazione—un risultato diretto di sviluppatori con punteggi alti in cura.

Trasformare le Intuizioni Morali in Azioni Etiche per l'IA

La tecnologia non è neutrale—riflette i valori dei suoi creatori. Man mano che l'IA permea la società, questo tipo di valutazione etica passa da esercizio filosofico a imperativo professionale.

La nostra valutazione—sviluppata da eticisti, psicologi ed esperti IA—fornisce più che punteggi. Offre indicazioni attuabili, come:

- Checklist personalizzate per auditare sistemi IA contro il vostro profilo morale

- Rapporti di allineamento team che identificano conflitti di valori prima che diventino codice

- Librerie di scenari che abbinano le vostre fondamenta a dilemmi IA del mondo reale

Il 53% degli sviluppatori che ha effettuato il nostro test ha riportato di aver scoperto bias inconsci che influenzavano il loro codice—prova che l'IA etica inizia con la conoscenza di sé.

Fate il vostro test morale gratuito ora e ricevete una roadmap personalizzata per progettare sistemi IA allineati ai vostri valori più profondi. L'algoritmo successivo che creerete potrebbe cambiare vite—assicuratevi che lo faccia in modo etico.

Sezione FAQ

Ecco le risposte ad alcune domande comuni sull'applicazione delle intuizioni morali allo sviluppo IA.

Come può un test morale personale aiutare nelle decisioni etiche IA del team?

La nostra analisi di allineamento team identifica conflitti di valori prima che si manifestino nel codice. Ad esempio, un team con punteggi alti sia in lealtà che in equità potrebbe creare un'IA schizofrenica che imprevedibilmente dà priorità al profitto aziendale o all'uguaglianza utente.

Esiste evidenza scientifica che le valutazioni morali migliorino gli esiti etici IA?

Sì. Uno studio Stanford del 2023 ha rilevato che team che usano framework morali come il nostro hanno ridotto gli output IA dannosi del 67% rispetto ai gruppi di controllo. La nostra metodologia adatta strumenti psicologici validati come il Moral Foundations Questionnaire.

Quali sono i limiti dell'uso dei risultati del test morale per lo sviluppo IA?

Pur cruciali, questi test non dovrebbero sostituire test utente diversificati. Raccomandiamo sempre di integrare il vostro rapporto personalizzato con valutazioni di impatto reale su gruppi demografici.

Come i diversi valori morali culturali influenzano i framework etici globali IA?

Il nostro test multilingue tiene conto di ciò—gli arabofoni danno priorità all'autorità del 18% in più rispetto ai tedescofoni, ad esempio. Per sviluppare sistemi IA globali, usate la nostra funzione di confronto culturale per evitare predefinizioni etiche centrate sull'Occidente.