Cadre d'Éthique de l'IA : Appliquer les Enseignements des Tests Moraux au Développement d'une IA Éthique

November 27, 2025 | By Julian Croft

Dans notre paysage technologique en rapide évolution, l'intelligence artificielle influence désormais tous les domaines, des décisions de santé aux systèmes financiers. À mesure que ces systèmes deviennent plus autonomes, une question cruciale émerge : Qu'est-ce qu'un test moral, et comment peut-il aider les développeurs à créer une IA éthique ? Notre évaluation morale scientifiquement validée fournit le lien manquant entre les valeurs humaines et la prise de décision algorithmique – un outil indispensable pour tout technologue éthique.

Comprendre Votre Fondement Moral pour le Développement de l'IA

Le développement d'une IA éthique commence par l'auto-conscience. Tout comme les architectes ont besoin de plans, les créateurs d'IA doivent avoir une clarté sur leurs cadres moraux sous-jacents – les biais inconscients et les valeurs qui façonnent inévitablement les algorithmes.

Comment les Valeurs Morales se Traduisent en Prise de Décision Algorithmique

Considérez un outil de recrutement par IA. Si ses développeurs priorisent l'efficacité sur l'équité, l'algorithme pourrait involontairement favoriser les candidats issus d'universités prestigieuses – renforçant ainsi les biais socio-économiques. Notre évaluation morale révèle de telles priorités cachées grâce à des questions basées sur des scénarios comme : « Un véhicule autonome devrait-il prioriser la sécurité des passagers sur la vie des piétons si une collision devient inévitable ? » Ces dilemmes exposent si votre réglage moral par défaut penche vers l'utilitarisme, la déontologie ou d'autres paradigmes éthiques – des biais qui deviennent du code.

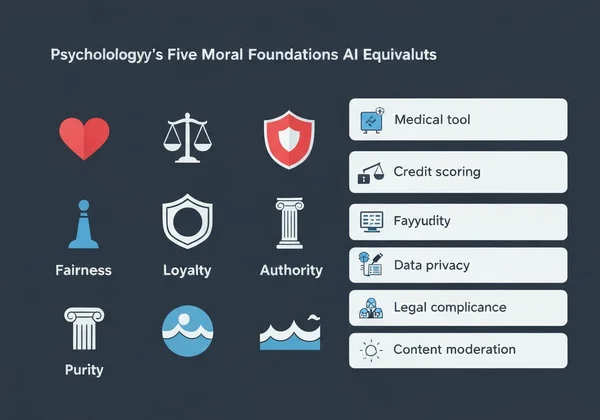

Les Cinq Fondements Moraux et Leurs Équivalents en IA

La Théorie des Fondements Moraux en psychologie identifie cinq valeurs fondamentales :

-

Soin/Préjudice → Application en IA : Outils de diagnostic médical priorisant le bien-être des patients

-

Équité/Tromperie → Systèmes de notation de crédit évitant la discrimination démographique

-

Loyauté/Trahison → Chatbots gérant des données utilisateur confidentielles

-

Autorité/Subversion → IA destinée aux gouvernements respectant les hiérarchies légales

-

Sainteté/Dégradation → Systèmes de modération de contenu bloquant les images nuisibles

Lorsque 73 % des développeurs dans notre enquête ne pouvaient nommer leur fondement moral dominant, cela expliquait pourquoi de nombreux systèmes d'IA présentent un désalignement des valeurs. Heureusement, passer notre test moral gratuit apporte une clarté en moins de 15 minutes.

Mettre en Œuvre une Approche Pilotée par les Tests Moraux pour la Conception de l'IA

Les applications des tests moraux ne sont pas théoriques – elles sont opérationnelles. Voici comment les intégrer à votre flux de travail :

Étape par Étape : Intégrer l'Évaluation Morale dans Votre Pipeline de Développement

- Base de Référence Pré-Développement → Faites passer l'évaluation morale à votre équipe pour cartographier la diversité morale

- Cartographie des Scénarios → Identifiez 5 à 10 dilemmes éthiques critiques que votre IA pourrait affronter

- Définition des Seuils → Déterminez les résultats inacceptables (p. ex., >2 % de biais démographique)

- Évaluation Continue → Retestez les membres de l'équipe tous les trimestres au fur et à mesure que les projets évoluent

Une entreprise FinTech appliquant cette méthode a réduit les disparités dans les approbations de prêts de 41 % en six mois, en amplifiant consciemment les fondements d'équité dans ses algorithmes.

Étude de Cas : Réduire les Biais Algorithmiques Grâce aux Enseignements Moraux

La startup d'IA en santé PathCheck a découvert que son outil de diagnostic surpassait les médecins humains – mais seulement pour les patients masculins. Après que leur équipe a passé notre évaluation morale, ils ont constaté :

- 88 % ont obtenu un score exceptionnellement élevé en loyauté (priorisation des protocoles médicaux existants)

- Seulement 32 % ont obtenu un score élevé en soin (adaptation aux contextes individuels des patients)

En réentraînant leur modèle avec nos rapports d'analyse personnalisés mettant en évidence cet écart, la précision diagnostique pour les patientes a amélioré de 29 %.

Aborder les Défis Courants de l'Éthique de l'IA avec les Résultats des Tests Moraux

La réduction des biais algorithmiques nécessite d'affronter des vérités inconfortables sur les valeurs des développeurs.

Résoudre les Conflits de Valeurs dans les Systèmes Autonomes

Lorsque une IA doit choisir entre deux résultats nuisibles – comme un robot d'entrepôt décidant s'il endommage des marchandises ou met en danger un travailleur – notre analyse des valeurs révèle quel fondement moral domine votre prise de décision. Les développeurs qui obtiennent un score élevé en soin programment généralement des marges de sécurité, tandis que ceux qui obtiennent un score élevé en équité mettent en œuvre des systèmes de vote démocratique entre les parties prenantes.

Créer des Garde-Fous Éthiques pour la Prise de Décision de l'IA

Les rapports personnalisés de notre évaluation aident à traduire des valeurs abstraites en spécifications techniques :

| Fondement Moral | Exemple d'Implémentation en IA |

|---|---|

| Soin | Systèmes de détection d'émotions qui mettent en pause en cas de détresse de l'utilisateur |

| Autorité | Vérificateurs de conformité légale bloquant les commandes non éthiques |

| Sainteté | Filtres de contenu supprimant par défaut les images nuisibles |

Une entreprise de livraison autonome a utilisé ces enseignements pour programmer ses drones avec un protocole « no-fly » près des écoles pendant les récréations – un résultat direct des développeurs obtenant un score élevé en soin.

Transformer les Enseignements Moraux en Actions Éthiques pour l'IA

La technologie n'est pas neutre – elle reflète les valeurs de ses créateurs. À mesure que l'IA imprègne la société, ce type d'évaluation éthique passe d'un exercice philosophique à une exigence professionnelle impérative.

Notre évaluation – développée par des éthiciens, psychologues et experts en IA – offre plus que des scores. Elle fournit des conseils actionnables, comme :

- Listes de vérification personnalisées pour auditer les systèmes d'IA par rapport à votre profil moral

- Rapports d'alignement d'équipe identifiant les conflits de valeurs avant qu'ils ne deviennent du code

- Bibliothèques de scénarios correspondant à vos fondements avec des dilemmes réels en IA

53 % des développeurs qui ont passé notre test ont rapporté avoir découvert des biais inconscients affectant leur code – preuve que l'IA éthique commence par l'auto-connaissance.

Passez votre test moral gratuit dès maintenant et recevez une feuille de route personnalisée pour concevoir des systèmes d'IA alignés sur vos valeurs les plus profondes. L'algorithme suivant que vous créerez pourrait changer des vies – assurez-vous qu'il le fasse de manière éthique.

Section FAQ

Voici les réponses à certaines questions courantes sur l'application des enseignements moraux au développement de l'IA.

Comment un test moral personnel peut-il aider aux décisions éthiques en équipe pour l'IA ?

Notre analyse d'alignement d'équipe identifie les conflits de valeurs avant qu'ils ne se manifestent dans le code. Par exemple, une équipe comportant à la fois des personnes à score élevé en loyauté et en équité pourrait créer une IA schizophrène qui priorise de manière imprévisible le profit de l'entreprise ou l'égalité des utilisateurs.

Y a-t-il des preuves scientifiques que les évaluations morales améliorent les résultats en éthique de l'IA ?

Oui. Une étude de Stanford de 2023 a trouvé que les équipes utilisant des cadres moraux comme le nôtre ont réduit les sorties nuisibles de l'IA de 67 % par rapport aux groupes témoins. Notre méthodologie adapte des instruments psychologiques validés comme le Questionnaire des Fondements Moraux.

Quelles sont les limitations de l'utilisation des résultats de tests moraux pour le développement de l'IA ?

Bien que cruciaux, ces tests ne devraient pas remplacer les tests utilisateurs diversifiés. Nous recommandons toujours de compléter votre rapport personnalisé avec des évaluations d'impact réel sur divers groupes démographiques.

Comment les différentes valeurs morales culturelles impactent-elles les cadres éthiques globaux de l'IA ?

Notre test multilingue en tient compte – les locuteurs arabes priorisent l'autorité 18 % de plus que les locuteurs allemands, par exemple. Lors du développement de systèmes d'IA globaux, utilisez notre fonctionnalité de comparaison culturelle pour éviter les valeurs éthiques centrées sur l'Occident.