Marco de Ética en IA: Aplicando los conocimientos de las pruebas morales al Desarrollo de IA Ética

November 27, 2025 | By Julian Croft

En nuestro panorama tecnológico en rápida evolución, la inteligencia artificial ahora influye en todo, desde decisiones de atención sanitaria hasta sistemas financieros. A medida que estos sistemas se vuelven más autónomos, surge una pregunta crítica: ¿Qué es una prueba moral, y cómo puede ayudar a los desarrolladores a crear IA ética? Nuestra evaluación moral validada científicamente proporciona el vínculo perdido entre los valores humanos y la toma de decisiones algorítmicas—una herramienta que todo tecnólogo ético necesita.

Entendiendo Tu Fundación Moral para el Desarrollo de IA

El desarrollo de IA ética comienza con la autoconciencia. Así como los arquitectos necesitan planos, los creadores de IA necesitan claridad sobre sus marcos morales subyacentes—los sesgos y valores inconscientes que inevitablemente moldean los algoritmos.

Cómo los Valores Morales se Traducen en la Toma de Decisiones Algorítmicas

Considera una herramienta de reclutamiento con IA. Si sus desarrolladores priorizan la eficiencia sobre la equidad, el algoritmo podría favorecer inadvertidamente a candidatos de universidades prestigiosas—reforzando sesgos socioeconómicos. Nuestra evaluación moral revela tales prioridades ocultas mediante preguntas basadas en escenarios como: "¿Debería un vehículo autónomo priorizar la seguridad del pasajero sobre las vidas de peatones si la colisión es inevitable?" Estos dilemas exponen si tu configuración moral predeterminada se inclina hacia el utilitarismo, la deontología u otros paradigmas éticos—sesgos que se convierten en código.

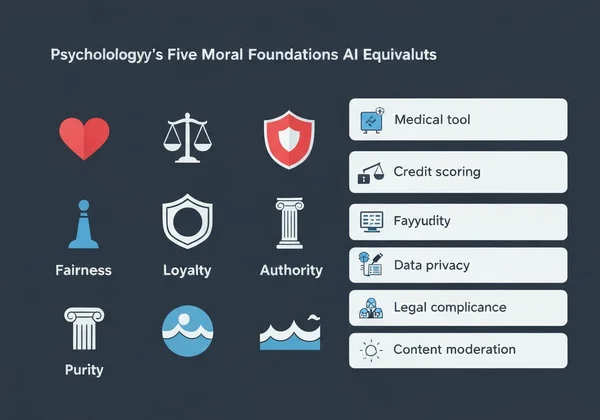

Los Cinco Fundamentos Morales y Sus Equivalentes en IA

La Teoría de los Fundamentos Morales de la psicología identifica cinco valores centrales:

-

Cuidado/Daño → Aplicación en IA: Herramientas de diagnóstico médico que priorizan el bienestar del paciente

-

Equidad/Engaño → Sistemas de puntuación crediticia que evitan la discriminación demográfica

-

Lealtad/Traición → Chatbots que manejan datos confidenciales de usuarios

-

Autoridad/Subversión → IA orientada al gobierno que respeta jerarquías legales

-

Pureza/Degradación → Sistemas de moderación de contenido que bloquean imágenes perjudiciales

Cuando el 73% de los desarrolladores en nuestra encuesta no pudieron nombrar su fundamento moral dominante, explicó por qué muchos sistemas de IA exhiben desalineación de valores. Afortunadamente, realizar nuestra prueba moral gratuita proporciona claridad en menos de 15 minutos.

Implementando un Enfoque Impulsado por Pruebas Morales en el Diseño de IA

Las aplicaciones de pruebas morales no son teóricas—son operativas. Así es como integrarlas en tu flujo de trabajo:

Paso a Paso: Integrando la Evaluación Moral en Tu Pipeline de Desarrollo

- Línea Base Pre-Desarrollo → Haz que tu equipo realice la evaluación moral para mapear la diversidad moral

- Mapeo de Escenarios → Identifica 5-10 dilemas éticos críticos que tu IA podría enfrentar

- Establecimiento de Umbrales → Determina resultados inaceptables (p. ej., >2% de sesgo demográfico)

- Evaluación Continua → Vuelve a evaluar a los miembros del equipo trimestralmente a medida que evolucionan los proyectos

Una empresa FinTech que aplicó este método redujo las disparidades en aprobaciones de préstamos en un 41% en seis meses al amplificar conscientemente los fundamentos de equidad en sus algoritmos.

Estudio de Caso: Reduciendo el Sesgo Algorítmico a Través de Conocimientos Morales

La startup de IA en salud PathCheck descubrió que su herramienta de diagnóstico superaba a los médicos humanos—pero solo para pacientes masculinos. Después de que su equipo realizó nuestra evaluación moral, encontraron:

- El 88% obtuvo puntuaciones excepcionalmente altas en lealtad (priorizando protocolos médicos existentes)

- Solo el 32% obtuvo puntuaciones altas en cuidado (adaptación a contextos individuales de pacientes)

Al reentrenar su modelo con informes de análisis personalizados que destacaban esta brecha, la precisión diagnóstica para pacientes femeninas mejoró en un 29%.

Abordando Desafíos Comunes de Ética en IA con Resultados de Pruebas Morales

Reducción de sesgo algorítmico requiere confrontar verdades incómodas sobre los valores de los desarrolladores.

Resolviendo Conflictos de Valores en Sistemas Autónomos

Cuando una IA debe elegir entre dos resultados dañinos—como un robot de almacén decidiendo si dañar mercancías o arriesgar lesiones a un trabajador—nuestro análisis de valores revela qué fundamento moral domina tu toma de decisiones. Los desarrolladores que puntúan alto en cuidado suelen programar búferes de precaución, mientras que los que puntúan alto en equidad implementan sistemas de votación democrática entre interesados.

Creando Barreras Éticas para la Toma de Decisiones de IA

Los informes personalizados de nuestra evaluación ayudan a traducir valores abstractos en especificaciones técnicas:

| Fundamento Moral | Ejemplo de Implementación en IA |

|---|---|

| Cuidado | Sistemas de detección de emociones que pausan durante el malestar del usuario |

| Autoridad | Verificadores de cumplimiento legal que bloquean comandos contrarios a la ética |

| Pureza | Filtros de contenido que eliminan imágenes perjudiciales por defecto |

Una empresa de entregas autónomas usó estas perspectivas para programar sus drones con un protocolo de «no vuelo» cerca de escuelas durante las horas de recreo—un resultado directo de desarrolladores que puntuaron alto en cuidado.

Transformando los Conocimientos Morales en Acción Ética para IA

La tecnología no es neutral—refleja los valores de sus creadores. A medida que la IA permea la sociedad, este tipo de evaluación ética pasa de ser un ejercicio filosófico a una imperativa profesional.

Nuestra evaluación—desarrollada por eticistas, psicólogos y expertos en IA—entrega más que puntuaciones. Proporciona orientación accionable, como:

- Listas de verificación personalizadas para auditar sistemas de IA contra tu perfil moral

- Informes de alineación de equipo que identifican conflictos de valores antes de que se conviertan en código

- Bibliotecas de escenarios que relacionan tus fundamentos con dilemas reales de IA

El 53% de los desarrolladores que realizaron nuestra prueba reportaron descubrir sesgos inconscientes que afectan su código—prueba de que la IA ética comienza con el autoconocimiento.

Realiza tu prueba moral gratuita ahora y recibe un mapa de ruta personalizado para diseñar sistemas de IA que se alineen con tus valores más profundos. El próximo algoritmo que crees podría cambiar vidas—asegúrate de que lo haga de manera ética.

Sección de Preguntas Frecuentes

Aquí hay respuestas a algunas preguntas comunes sobre la aplicación de conocimientos morales al desarrollo de IA.

¿Cómo puede una prueba moral personal ayudar en las decisiones éticas de equipo para IA?

Nuestro análisis de alineación de equipo identifica conflictos de valores antes de que se manifiesten en código. Por ejemplo, un equipo con puntuaciones altas tanto en lealtad como en equidad podría crear una IA incoherente que prioriza impredeciblemente la ganancia de la empresa o la igualdad del usuario.

¿Hay evidencia científica de que las evaluaciones morales mejoran los resultados éticos en IA?

Sí. Un estudio de Stanford de 2023 encontró que equipos que usan marcos morales como el nuestro redujeron salidas dañinas de la IA en un 67% en comparación con grupos de control. Nuestra metodología adapta instrumentos psicológicos validados como el Cuestionario de Fundamentos Morales.

¿Cuáles son las limitaciones de usar resultados de pruebas morales para el desarrollo de IA?

Aunque cruciales, estas pruebas no deben reemplazar pruebas con usuarios diversos. Siempre recomendamos complementar tu informe personalizado con evaluaciones de impacto en el mundo real en diversos grupos demográficos.

¿Cómo impactan los diferentes valores morales culturales en los marcos éticos globales de IA?

Nuestra prueba multilingüe tiene en cuenta esto—los hablantes de árabe priorizan la autoridad un 18% más que los hablantes de alemán, por ejemplo. Al desarrollar sistemas de IA globales, usa nuestra función de comparación cultural para evitar valores éticos centrados en Occidente.